决策树的数据集(决策树数据集下载)

本篇目录:

1、决策树(decisionTree)2、10、决策树集成--随机森林3、决策树法的基本步骤4、决策树在大数据集训练方面有何优势?决策树(decisionTree)

决策树(Decision Tree)是在已知各种情况发生概率的基础上,通过构成决策树来求取净现值的期望值大于等于零的概率,评价项目风险,判断其可行性的决策分析方法,是直观运用概率分析的一种图解法。

决策论中(如风险管理),决策树(Decisiontree)由一个决策图和可能的结果(包括资源成本和风险)组成,用来创建到达目标的规划。决策树建立并用来辅助决策,是一种特殊的树结构。

决策树(decisionTree)是一种基本的分类和回归方法。此文仅讨论用于分类方法的决策树。决策树的学习通常分为3步:决策树的学习的思想主要源于 定义决策树 :分类决策树模型是一种描述对实例进行分类的树形结构。

决策树(Decision Tree)是一种基本的分类与回归方法,其模型呈树状结构,在分类问题中,表示基于特征对实例进行分类的过程。本质上,决策树模型就是一个定义在特征空间与类空间上的条件概率分布。

决策树(decision tree)算法思想:决策树是一种基本的分类与回归方法。本文主要讨论分类决策树。决策树模型呈树形结构,在分类问题中,表示基于特征对实例进行分类的过程。

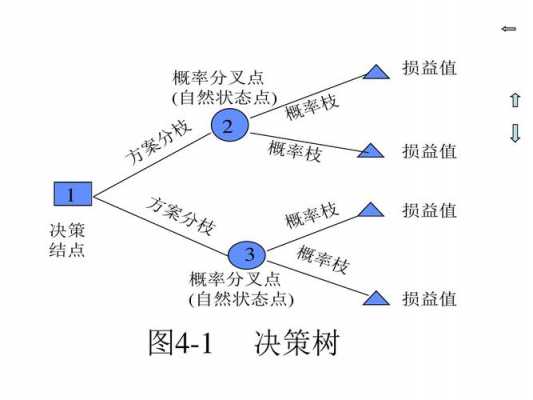

决策树(decisiontree)一般都是自上而下的来生成的。每个决策或事件(即自然状态)都可能引出两个或多个事件,导致不同的结果,把这种决策分支画成图形很像一棵树的枝干,故称决策树。

10、决策树集成--随机森林

二 每棵树随机选择特征,选择部分特征而不是全部。输出 在没有调节任何参数的情况下,随机森林的精度为97%,比分类算法(逻辑回归、线性SVM)或单棵决策树都要好。随机森林的默认参数通常就可以给出很好的结果。

简述数据挖掘中随机森林算法的原理,优点和主要参数随机森林是一个用随机方式建立的,包含多个决策树的分类器。其输出的类别是由各个树输出的类别的众数而定。

随机森林算法是基于决策树的集成学习算法,其核心思想是将多个决策树集合起来,以求取最优解。

继续下去,我们便产生了一棵决策树。随机森林是多棵决策树,在产生完一棵决策树后,接着会循环执行上述过程:Bootstrap 出训练样本,训练决策树,直到树的数量达到设置值——通常为几百棵树。

决策树法的基本步骤

1、决策树分析方法的基本步骤 绘制决策树图。从左到右的顺序画决策树,此过程本身就是对决策问题的再分析过程。按从右到左的顺序计算各方案的期望值,并将结果写在相应方案节点上方。

2、决策树法的几个关键步骤是:画出决策树,画决策树的过程也就是对未来可能发生的各种事件进行周密思考、预测的过程,把这些情况用树状图表示出来.先画决策点,再找方案分枝和方案点.最后再画出概率分枝。

3、利用决策树进行决策的过程是由右向左,逐步后退。根据右端的损益值和概率枝上的概率,计算出同一方案的期望损益值的大小来选择最优方案。

决策树在大数据集训练方面有何优势?

用决策树训练大量数据集最节约时间的是减少树的深度。

那么决策树自身的优点都有什么呢,总结下来就是有六点,第一就是决策树易于理解和解释,可以可视化分析,容易提取出规则。第二就是可以同时处理标称型和数值型数据。第三就是比较适合处理有缺失属性的样本。

减少数的深度用决策树法训练大量数据集最节约时间。决策树分析法是一种运用概率与图论中的树对决策中的不同方案进行比较,从而获得最优方案的风险型决策方法。

下面用决策树法训练最节约时间的是减少数。决策树模型因为其特征预处理简单、易于集成学习、良好的拟合能力及解释性,是应用最广泛的机器学习模型之一。决策树算法在决策领域有着广泛的应用,比如个人决策、公司管理决策等。

到此,以上就是小编对于决策树数据集下载的问题就介绍到这了,希望介绍的几点解答对大家有用,有任何问题和不懂的,欢迎各位老师在评论区讨论,给我留言。

- 1bat的大数据(BAT的大数据来源)

- 2三星s8屏幕上端2(三星s8屏幕上端2个按键)

- 3三星屏幕坏了如何导出(三星屏幕摔坏了如何导出数据么)

- 4红米3x怎么关闭自动更新(红米k40s怎么关闭自动更新)

- 5微信上防止app自动下载软件怎么办(微信上防止app自动下载软件怎么办啊)

- 6押镖多少钱(押镖一个月有多少储备金)

- 7瑞星个人防火墙胡功能(瑞星个人防火墙协议类型有哪些)

- 8cf现在等级是多少(cf等级2020最新)

- 9老滑头多少条鱼(钓鱼老滑头有什么用)

- 10WPS自动调整语法(wps如何修改语法)

- 11dell控制面板防火墙(dell的防火墙怎么关闭)

- 12丑女技能升多少(丑女技能需要满级吗)

- 13智能家居系统怎么样(智能家居系统好吗)

- 14戴尔屏幕(戴尔屏幕闪烁)

- 15y85屏幕信息(vivoy85息屏显示时间怎么设置)

- 16魅蓝note3屏幕出现方格(魅蓝note屏幕竖条纹)

- 17v8手指按屏幕(触屏手指)

- 18金为液晶广告机(液晶广告机lb420)

- 19三星显示器怎么校色(三星显示器 调色)

- 20hkc显示器dvi音频(hkc显示器有音响么)

- 21康佳液晶智能电视机(康佳液晶智能电视机怎么样)

- 22做液晶画板电脑(做液晶画板电脑怎么操作)

- 23液晶屏极化现象原理(液晶屏极化现象原理是什么)

- 24企业网络安全防火墙(企业网络防护)

- 256splus黑屏屏幕不亮(苹果6s plus屏幕突然黑屏)

- 26充电导致屏幕失灵(充电导致屏幕失灵怎么办)

- 27超极本屏幕旋转(笔记本电脑屏幕旋转,怎么转过来?)

- 28igmp防火墙(防火墙配置ipv6)

- 29荣耀王者多少经验(王者荣耀经验多少一级)

- 30lol老将还剩多少(qg老将)